MCP Server

Tuy nhiên nếu bạn hỏi tình hình dự án X ở công ty F thế nào, tiến độ đến đâu, đang cháy hay đang on-schedule. Hỏi thăm em nhân viên có account XXX sinh năm bao nhiêu, có chồng chưa thì em nó chịu chết. Bởi vì nguồn datasource này private không có trên internet, nó là dữ liệu nội bộ.

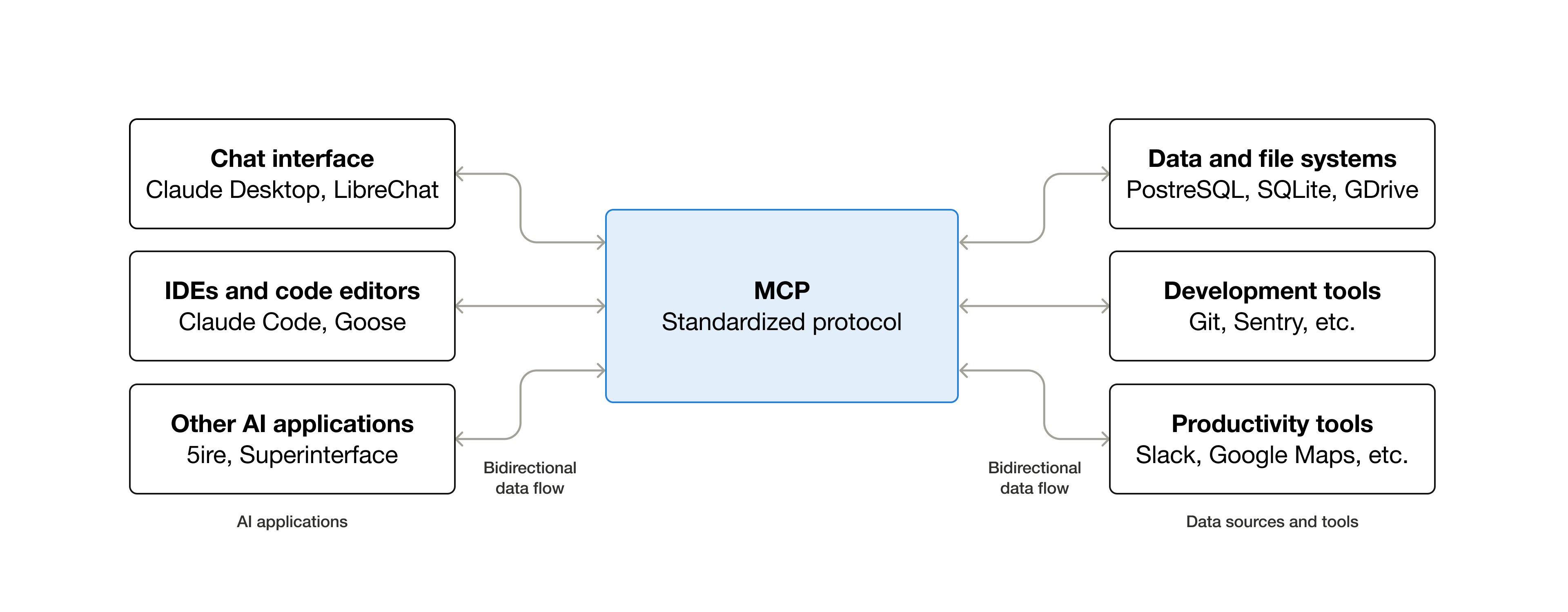

Thế là Anthropic mới phát minh ra giao thức gọi là MCP, cho phép kết nối AI với các công cụ, ứng dụng hoặc cơ sở dữ liệu bên thứ ba

MCP server là một proxy server, hiểu nhanh là một cái chìa khoá để AI có thể mở kết nối với 3rd tool/data

Và viễn cảnh là thành hiện thực

- BA chỉ việc gửi link Specs cho AI nó phân tích bóc tách ra SRS

- PM xài AI từ SRS ra luôn Work break down task, rồi nhờ em nó tạo ticket luôn trên Jira hoặc Azure DevOps

- Dev pick ticket về chạy prompt gen code

- Test gen AT code, tạo test case

- Sale vào product đi chém gió

- Lính lác level thấp chỉ còn nước về quê chăn vịt

LLM Guardrails

Người xài LLM bên cạnh những câu hỏi phục vụ công việc đôi khi cũng gạ gẫm em LLM nhiều thứ 18+, bạo lực nhưng xin link JAV, nội dung bậy bạ, dần dần dẫn dắt em nó vào đời.

Ngược lại, LLM cũng trả lời user những câu nghe rất thuyết phục nhưng vô lý đùng đùng, ngôn ngữ tech là hallucinations, còn non-tech gọi là trả lời xạo choá.

Cuối cùng là user làm hư LLM, còn LLM cũng đưa user vào con đường ma đạo, kiểu tôi là ai và đây là đâu, cả 2 cùng nát

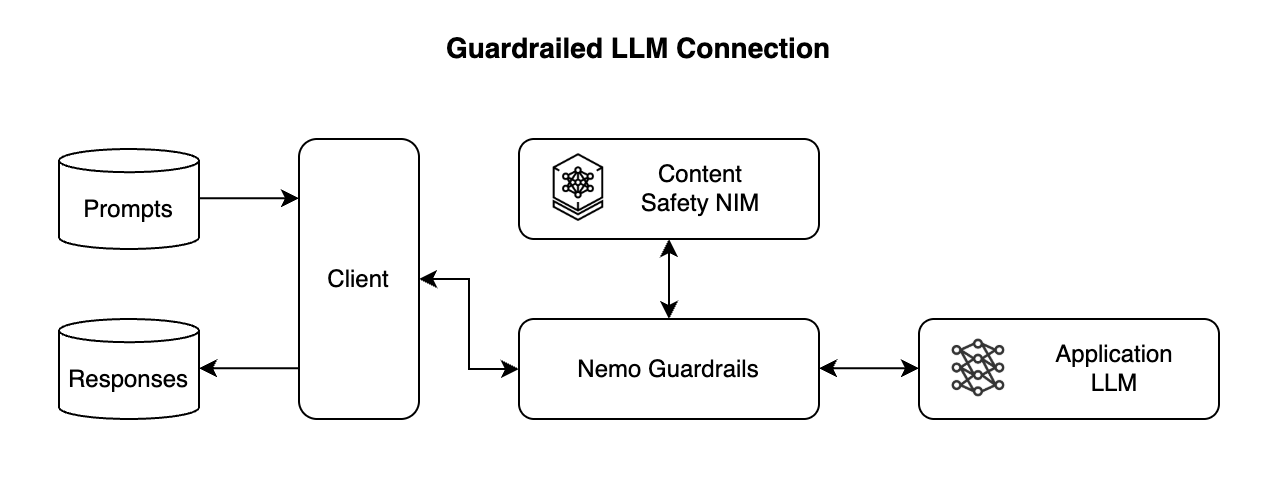

Thế là NVidia phát minh ra LLM Guardrails. gọi là cảnh sát AI, nằm giữa LLM và người dùng, để kiểm duyệt nội dung đầu vào đầu ra của LLM.

Cảnh sát AI làm việc thì phải theo luật, đó là mechanisms, rules, and policies định nghĩa trước để kiểm soát LLM.

Ví dụ, user mà gạ (prompt) LLM tối nay đi nhà nghỉ, thì Guardrail sẽ detect dc những keyword cấm (define trong policy) chặn luôn, em nó là gái nhà lành, chú đừng có gạ gẫm, prompt câu khác đi, cho câu hỏi đến LLM. Quá trình này là Pre-processing/Pre-inference

Tương tự khi LLM output response thì lại qua Guardrails kiểm tra trước khi trả về user. Ví dụ một câu trả lời có chứa PII data sẽ bị mask đi, censored che đi chỗ kín, nội dung chứa thông tin bậy bạ làm hư user sẽ bị block luôn

Từ ngày có Guardrails, thì hỏi ChatGPT xin link cũng ko dễ nữa, nó sẽ trả lời “Mình xin lỗi, mình không thể giúp bạn tìm hoặc chia sẻ link đến nội dung xxx.” Muốn có thì chỉ ib vùng kín

Mấy bộ SDK này cung cấp full module để tạo dataset, tạo train jobs , deploy model vào endpoint. Ưu điểm là có thể tích hợp vào CI/CD như Gitlab CI, Jenkins, Azure DevOps, cutomize theo ý thích. Nếu code python mượt thì nên chọn cách này, mỗi tội phải build từ đầu đến cuối tốn cơm.

Tuy nhiên nếu chọn giải pháp full machine learning trên nền tảng Azure thì có thể tham khảo em này

Một dạng boostrap e2e framework MLOPs, các pipeline buid train model được tạo thành dạng template, Infra cơ bản dựng sẵn boostrap bằng terraform. Giải pháp nhanh ngọn mỳ ăn liền cho team nào cần dựng MLOps infra nhanh

Training metrics

Thầy giáo dạy học cũng phải theo dõi tình hình học sinh nó học hành thế nào, có hiểu hết bài không, dạy mười thì check xem nó học được mấy, ghi chép số liệu để gửi về cho phụ huynh. Training AI cũng tương tự, cũng cần training metrics, và thế là MLflow, wandb, tensorboard ra đời để xử lý cái này

0 Nhận xét